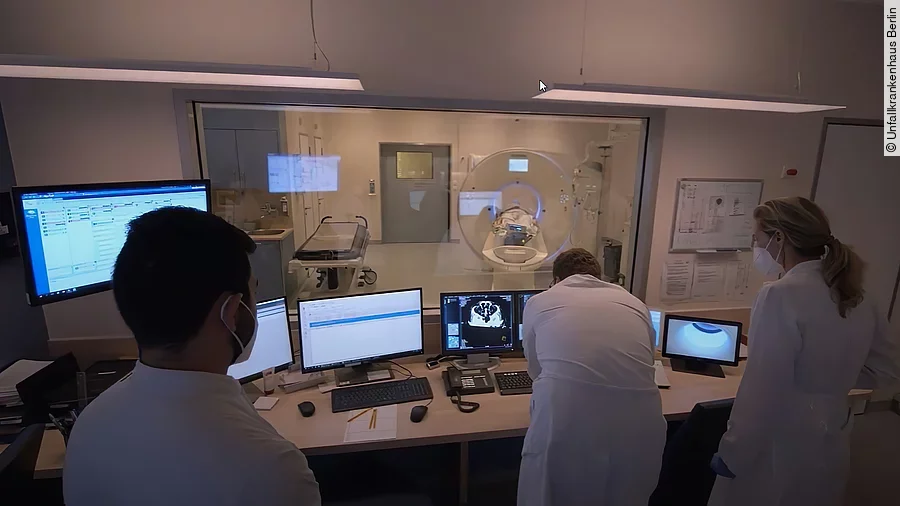

Die Warnung des virtuellen Kollegen ist unübersehbar. Auf dem Bildschirm leuchtet es gelb und rot, das CT-Bild rutscht wie von Geisterhand auf der Liste der eingehenden CT-Bilder automatisch an die Spitze. Für Dr. Leonie Gölz, die gerade in der Radiologie des Unfallkrankenhauses Berlin (ukb) CT-Bilder von Schädeln betrachtet, ist es die eindeutige Botschaft, sich dieses CT-Bild nun bevorzugt genauer anzuschauen. Streng genommen ist der Kollege eigentlich keiner, sondern eine künstliche Intelligenz (KI) im Computer. Doch auch deren Expertise ist exzellent und sehr verlässlich, wenn es darum geht, auf CT-Bildern intrakranielle Blutungen, also Blutungen innerhalb des Schädels, zu erkennen.

Seit 2021 nutzen Gölz und ihre Kolleginnen und Kollegen am Unfallklinikum das Programm des israelischen KI-Anbieters „AIDOC“, um diese Blutungen schneller und besser zu erkennen. Hirnblutungen stellen einen schweren Notfall dar und sind gefürchtet, weil sie schwere Hirnschäden verursachen und unbehandelt zum Tod führen können. Das schnelle Erkennen und Reagieren auf diese Hirnblutungen ist jedoch essenziell für eine erfolgreiche Behandlung des Patienten.

„Wir haben uns für den Einsatz der KI entschieden, weil wir Teil eines teleradiologischen Netzwerkes mit insgesamt 22 Krankenhäusern sind“, erzählt Prof. Sven Mutze, Direktor des Instituts für Radiologie und Neuroradiologie am ukb. Jährlich werden nach seinen Angaben allein in seinem BG Klinikum bis zu 30 000 CT-Bilder gemacht, hinzukommen weitere 30 000 über das teleradiologische Netzwerk. Täglich fällt so eine enorme Menge an Bildern zur Befundung für die Radiologen an. „Sie können sich vorstellen, wenn nachts akute Schädel-CTs aus all diesen Krankenhäusern - teilweise auch parallel – hier bei uns eingehen, wird das für den diensthaben Radiologen zur Herausforderung. Das Problem ist nicht, dass dieser die Blutung erkennt, sondern ob er rechtzeitig auf das richtige Bild schaut

KI als „second reader“ der CT-Bilder

An diesem Punkt unterstützt nun die KI die Ärzte. Sie screent im Hintergrund alle einlaufenden CT-Bilder („second reading“) auf den Verdacht von Blut im Hirn. Wenn sie fündig wird, poppt es augenblicklich rot auf dem Bildschirm auf, das Bild rutscht in der Liste der einlaufenden Bilder automatisch nach oben und warnt die Mediziner, hier könnte Blut im Schädel sein. Es ist wie eine Zweitbefundung durch einen Kollegen, die „uns dabei hilft, das richtige Bild zum richtigen Zeitpunkt anzugucken. Das ist enorm wichtig und verbessert unsere Arbeit“, urteilt Prof. Mutze.

Die KI ersetzt dabei keinen Radiologen, sonst ergänzt deren Arbeit und verbessert so grundsätzlich die Qualität die Diagnostik, sagt Dr. Leonie Gölz. Sie erinnert daran, dass es im Umland von Berlin Krankenhäuser gebe, die viel weniger verunfallte Patienten behandeln als die Ärzte im ukb und entsprechend weniger Schädel-CT zu Gesicht bekommen würden. Wie gut dann die Diagnostik verlaufe, sei dann auch eine Frage der Erfahrung des jeweiligen Radiologen. „KI jedoch arbeitet immer mit gleichbleibender Qualität. Sinn und Zweck des Einsatzes von KI ist daher, einfach noch besser zu werden. Und wir haben festgestellt, dass wir zusammen mit der KI das beste Ergebnis erzielen können“, sagt die Radiologin.

Die positive Rolle der KI im klinischen Alltag des ukb lässt sich mit konkreten Zahlen belegen. Das Team um Prof. Mutze und Dr. Gölz hat das Wirken der KI im radiologischen Betrieb wissenschaftlich untersucht und dazu eine eigene Studie im renommierten internationalen Fachmagazin „PLOS ONE“ veröffentlicht. Danach hat der Einsatz der Künstlichen Intelligenz die Erkennungsrate von intrakraniellen Blutungen am ukb um 12,2 Prozent verbessert.

Die Entscheidung der Berliner für „Aidoc“ ist den besonderen Datenschutzgegebenheiten in Deutschland geschuldet, wie die beiden Radiologen im Gespräch durchblicken lassen. Das israelische Technologieunternehmen ist nicht der einzige Anbieter derartiger KI-Dienstleistungen, aber es verfügt über einen großen Schatz an Datensätzen aus zahlreichen Ländern, weil es international mit Krankenhäusern kooperiert – und international die Nutzung medizinischer Daten nicht so strikt gehandhabt wird wie in Deutschland. „Wir haben vorab zahlreiche Firmen gescreent und mit vielen Unternehmen hier immer wieder das gleiche Thema gehabt. Diese wollten von uns Daten haben, hatten aber selbst noch kein gutes Produkt“, schildert Prof. Mutze. Man sei zwar ein leistungsfähiges Krankenhaus, Forschung finde hier aber nicht in der Größenordnung statt, wie das an einer Uniklinik der Fall sei, sagt der Radiologe. „Dennoch möchten wir KI nutzen. Aidoc arbeitet international mit zahlreichen und guten klinischen Partnern zusammen und hat ihre KI-Netzwerke schon lange trainiert“, begründet er die Entscheidung für das israelische Unternehmen. „Aidoc hilft uns in der klinischen Routine, bekommt aber keine Daten von uns“, ergänzt Leonie Gölz.

Neue KI prüft gesamte Wirbelsäule

Für ein weiteres KI-Projekt stellt das ukb eigene und anonymisierte Daten zur Verfügung. Philipps entwickelt mit Unterstützung des BG-Klinikums eine KI-Applikation für die gesamte Wirbelsäule. „Das gibt es auf dem Markt meines Wissens bisher so noch nicht, daher unterstützen wir das Projekt“, sagt Prof. Mutze. Aufgrund der vielen Schwerverletzten, die im Unfallkrankenhaus behandelt werden, fallen in der Radiologie jährlich sehr viele Polytrauma-CTs an. Diese Patienten bekommen ein komplettes CT der Wirbelsäule. „Wenn sie sich aber die Anzahl der Wirbelkörper vorstellen, die der Mensch so hat, dann ist das einfach sehr viel Detailarbeit für den Radiologen, der die Polytrauma-CT befunden muss“, erläutert der Klinikdirektor. Konkret heißt das, dass zwei unterschiedliche Radiologen nach dem Vier-Augen-Prinzip sowie ein Unfallchirurg auf die Bilder schauen, was enorm arbeitsintensiv ist. „Da wäre es natürlich super, wenn eine KI im Hintergrund schon mal ein second reading vornehmen könnte“, meint Mutze.

Doch so einfach wie das zunächst klingt, ist es nicht. Ärzte und Softwareentwickler kämpfen aufgrund der Komplexität der menschlichen Wirbelsäule mit deutlich höheren Schwierigkeiten als bei der Suche nach Blut im Hirn. „Die Wirbelsäule ist ein komplexeres morphologisches System. Sie altert, auch die Wirbelkörper verändern sich im Alterungsprozess. Oder der Patient leidet an Osteoporose usw. Die Wirbelsäule ist über das Lebensalter sehr vielgestaltig, zudem ist die Halswirbelsäule anatomisch ganz anders aufgebaut als etwa die Lendenwirbelsäule“, erläutert Sven Mutze. Ein Hauptproblem sind bei der Entwicklung der KI sind falsch positive Fälle, was die Mediziner jedoch nicht beunruhigt. „Es ist in unserem Interesse, wenn die KI-Entwickler mit ihrer KI mehr sehen, als am Ende wirklich da ist. Wir erklären es ihnen – und sie können die Software dann besser trainieren“, sagt Mutze.

Analyse auf der Voxel-Ebene

In einem ersten Schritt stellte das ukb Philips rund 200 Datensätze zur Verfügung. Das klingt wenig, denn grundsätzlich gilt: Je mehr Datensätze eingesetzt werden, desto besser. Allerdings hängt die Qualität jedoch auch von der eingesetzten Methodik ab. „Wir nutzen Deep Learning und setzen CNN (Conventionell Neural Networks) ein, die mehrere Erkennungsstufen benutzen, um zu einer Aussage zu kommen. Das heißt, das maschinelle Lernen geht bei uns von der eingesetzten Methodik relativ tief“, erzählt Cristian Lorenz, der bei Philips die KI-Applikation mit entwickelt. „Beim Deep Learning wird selbständig eine Merkmalshierarchie gelernt, d.h. es wird gelernt, was in dem Bild eigentlich erkannt werden muss um dann die enstprechenden Schlüsse zu ziehen.“

Die Einschränkung durch wenige Datensätze umschiffen die Entwickler dadurch, dass sie jedes sogenannte „Voxel“ als eigenes Trainingselement für die Applikation betrachten. Ein Voxel (engl. zusammengesetzt aus volumetric und Pixel) ist das dreidimensionale Äquivalent eines Pixels. „Dadurch, dass wir bei Bruchstellen Hunderte oder Tausende von Voxeln haben, die an diesem Bruch beteiligt sind, haben wir selbst, den wir nur wenige Hundert Gesamtbilder haben, die relativ hohe Zahl an Voxeln. D.h., durch die Arbeit auf Voxel- Ebene erhöht sich die Trainingsmenge. Wir können so erstaunlicherweise mit nur wenigen Hundert Bildern schon gute Resultate erzielen“, so Lorenz.

Schon mit wenigen Datensätzen erreicht die KI eine Sensitivität von rund 85 Prozent. Sensitivität beschreibt den Prozentsatz von Patienten, bei denen die jeweilige Krankheit tatsächlich durch die KI erkannt wird. Perspektivisch soll die Sensitivität „möglichst hoch sein, im optimalen Fall bei 98 oder sogar mehr“, sagt Lorenz. Allerdings müssen die Entwickler gleichzeitig den Prozentsatz der „falsch positiven“ Ergebnisse niedrig halten, weil sonst der Aufwand für den Radiologen wieder steigt. Gesucht ist eine gute Mischung, die den Ärzten Zeit spart. Noch benötigt die KI eine Minute pro Bild, „unser Traum wären zehn Sekunden“, so Lorenz. Wann die KI-Applikation auf den Markt kommt, ist noch offen. Derzeit erfolgen das Feintuning und ein gemeinsamer Validierungsprozess mit den ukb-Ärzten.

Derzeit sind noch keine Kommentare vorhanden. Schreiben Sie den ersten Kommentar!

Jetzt einloggen